Czym jest crawl budget?

Crawl budget to limit stron, które roboty wyszukiwarek, takie jak Googlebot, mogą odwiedzić i zindeksować w określonym czasie. Można go porównać do biletów wstępu na koncert. Każda podstrona to jeden bilet, a liczba dostępnych biletów jest ograniczona.

Budżet indeksowania strony to ilość podstron, które Google może zaindeksować w czasie wizyty. Wpływa to na widoczność witryny w wynikach wyszukiwania.

Jeśli Twoja strona ma złą strukturę lub zawiera dużo duplikatów, roboty zmarnują swoje „bilety” na mniej ważne treści, pomijając te kluczowe. Oczywiście, nietrudno się domyślić, że wpływa to na pozycję Twojej witryny w wynikach wyszukiwania.

To połączenie dwóch czynników:

- crawl rate limit – maksymalnej liczby żądań do serwera,

- crawl demand – zapotrzebowania na indeksowanie.

Roboty wyszukiwarek, takie jak Googlebot, decydują o częstotliwości odwiedzin w zależności od tych parametrów.

Przykład:

Prowadzisz sklep internetowy z 10 000 produktów. Robot wyszukiwarki może odwiedzić tylko 500 z nich dziennie. Co się stanie z resztą? Jeśli kluczowe produkty nie zostaną zindeksowane, nie będą widoczne w Google – a to oznacza mniej ruchu na stronie i mniejsze zyski.

Co wpływa na crawl budget?

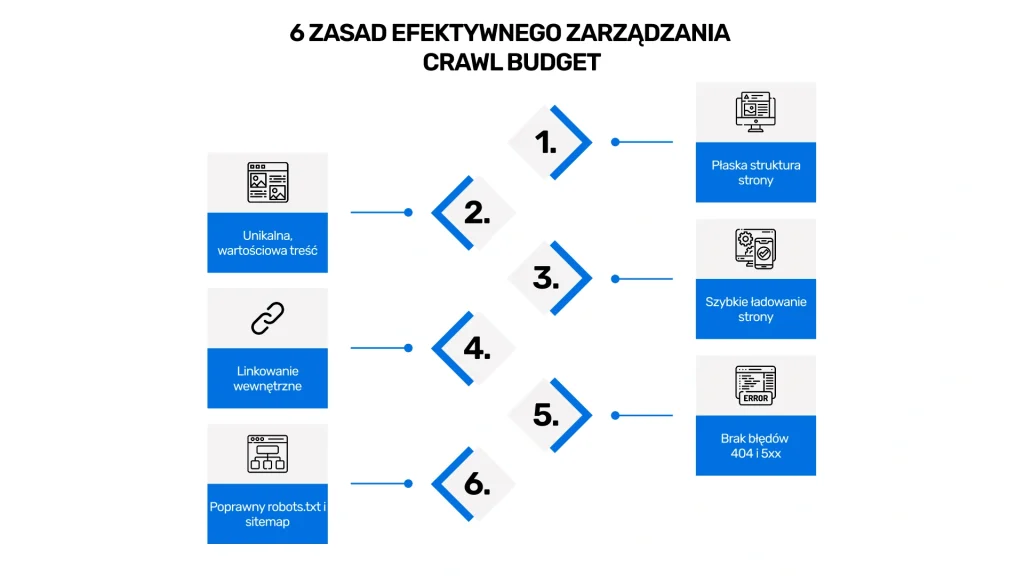

1. Rozmiar i struktura strony

Im większa witryna, tym więcej zasobów potrzebuje robot Google, by ją zindeksować. Zbyt głęboka lub chaotyczna struktura utrudni crawlowanie. Ważne jest również zarządzanie adresów url, aby uniknąć indeksowania niepotrzebnych stron, co zwiększa efektywność skanowania przez roboty Google.

Jak to poprawić?

- Utrzymuj płaską hierarchię stron (maksymalnie 3 kliknięcia do najważniejszych treści).

- Użyj wewnętrznych linków – w ten sposób ułatwisz nawigację.

2. Jakość treści

Google premiuje unikalne i wartościowe treści. Duplikaty i strony o niskiej wartości marnują crawl budget.

Jak to poprawić?

- Eliminuj zduplikowane treści i stosuj tagi kanoniczne

- Twórz angażujące teksty dopasowane do potrzeb użytkowników

3. Szybkość ładowania strony

Powolne strony ograniczają liczbę zaindeksowanych URL-i, ponieważ roboty nie mają czasu na dogłębne skanowanie.

Jak to poprawić?

- Optymalizuj kod HTML, CSS i JavaScript

- Kompresuj obrazy i skorzystaj z systemów cache

- Wykorzystuj narzędzia jak Google PageSpeed Insights

4. Linki wewnętrzne i zewnętrzne

Roboty Google śledzą linki na Twojej stronie, aby odnaleźć nowe treści. Brak odpowiednich linków jest w stanie ograniczyć crawlowanie.

Jak to poprawić?

- Dodaj linki wewnętrzne prowadzące do kluczowych podstron.

- Buduj wysokiej jakości backlinki, aby podnieść autorytet domeny.

5. Statusy HTTP i błędy serwera

Błędy 404 i 500 oraz zbyt wiele przekierowań mogą nie tylko zmarnować budżet indeksowania witryny

, ale także wpłynąć na crawl rate limit, ograniczając częstotliwość wizyt robotów Google.

Jak to poprawić?

- Monitoruj statusy HTTP za pomocą Google Search Console

- Naprawiaj błędy i unikał nadmiarowych przekierowań

6. Plik robots.txt i mapa strony (sitemap.xml)

Niewłaściwie skonfigurowany plik robots.txt blokuje ważne strony, a brak mapy strony utrudni ich odnalezienie.

Jak to poprawić?

- Sprawdź, czy plik robots.txt nie blokuje istotnych treści

- Regularnie aktualizuj mapę strony, aby zawierała tylko aktywne i istotne URL-e

Zajmiemy się marketingiem w Twojej firmie!

Wypełnij formularz i otrzymaj darmową wycenę

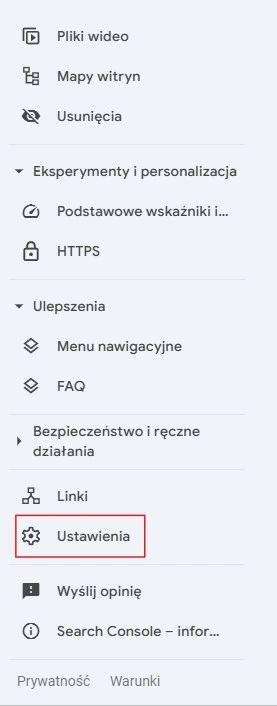

Jak sprawdzić crawl budget w Google Search Console?

Zaloguj się do Google Search Console. Najpierw wejdź na stronę Google Search Console i zaloguj się na swoje konto Google. Jeśli jeszcze nie masz konta, możesz je założyć bezpłatnie.

Po zalogowaniu wybierz stronę internetową, którą chcesz sprawdzić. Możesz dodać witrynę, jeśli jeszcze nie jest zarejestrowana w narzędziu.

Przejdź do ustawień. Po lewej stronie ekranu znajdziesz menu. Kliknij “Ustawienia”.

Możesz monitorować „częstotliwość indeksacji” w Google Search Console, aby optymalizować budżet indeksowania (crawl budget).

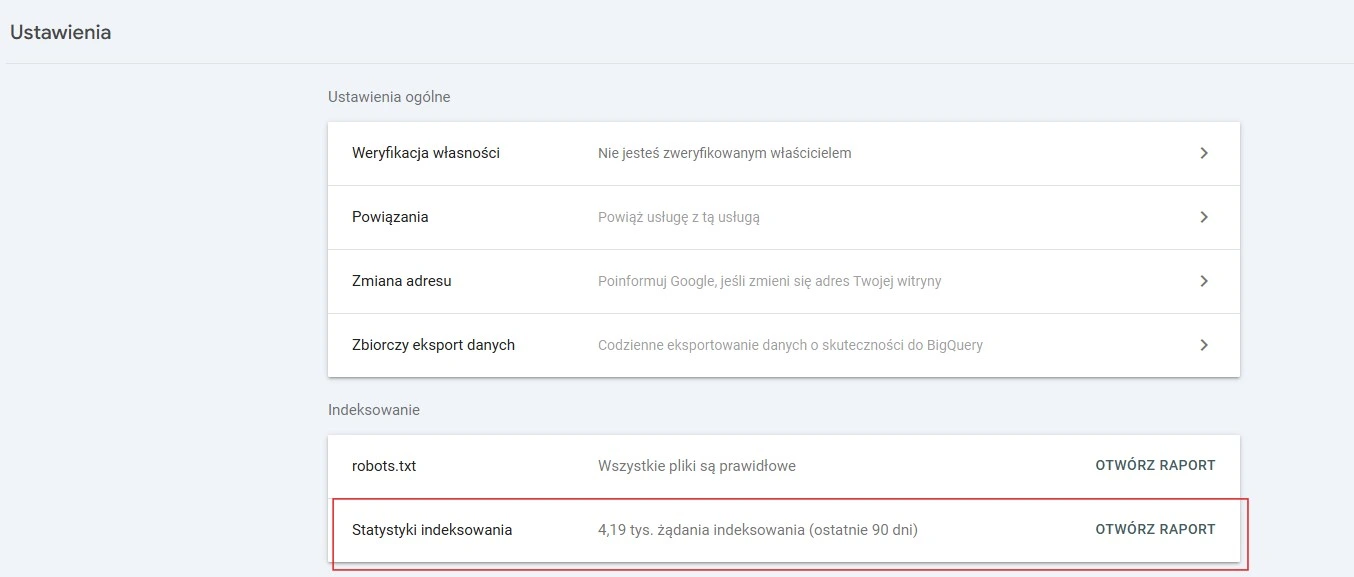

Potem przejdź do sekcji „Statystyki indeksowania”, a następnie kliknij “Otwórz raport”

Co znajdziesz w raporcie?

- Liczba żądań indeksowania – pokazuje, ile razy robot Google odwiedził Twoją stronę.

- Czas odpowiedzi serwera – wskazuje, jak szybko Twoja strona reaguje na zapytania Google.

- Pobrane dane – informuje o ilości danych (np. tekst, obrazy), które zostały pobrane podczas wizyty.

Przykład analizy danych

Załóżmy, że prowadzisz bloga z wieloma artykułami. W raporcie widzisz, że liczba żądań indeksowania nagle spadła. Co to może oznaczać?

- Twój serwer może być przeciążony i działa zbyt wolno.

- Plik robots.txt może blokować ważne strony.

- Masz duplikaty treści, które Google ignoruje.

Optymalizacja strony pod kątem budżetu indeksowania

Zadbaj o szybkość strony – roboty Google wolą szybkie strony. Optymalizuj czas ładowania, minimalizuj kod JavaScript i kompresuj obrazy. Pamiętaj, że strona, która ładuje się w 2 sekundy, zostanie częściej zindeksowana niż taka, która ładuje się 10 sekund.

Googlebot stara się indeksować optymalną ilość podstron, co jest kluczowe dla wydajności serwera i komfortu użytkowników. Crawl rate limit pomaga zbalansować proces indeksacji, aby uniknąć przeciążenia serwera i zapewnić szybsze działanie strony internetowej.

Uporządkuj strukturę witryny – stwórz logiczną nawigację. Ważne strony powinny być dostępne w maksymalnie 3 kliknięciach od strony głównej. Przykład:

- Strona główna > Kategorie > Produkt – dobra struktura.

- Strona główna > Kategorie > Podkategorie > Kolejne kategorie > Produkt – zbyt głęboka struktura.

Zaktualizuj sitemap.xml – upewnij się, że mapa strony zawiera tylko ważne i aktualne adresy URL. Usuń stare lub zduplikowane strony, aby nie marnować crawl budget.

Zablokuj niepotrzebne strony – użyj pliku robots.txt, aby wykluczyć strony, które nie powinny być indeksowane (np. strony logowania lub koszyki). Przykład kodu: User-agent: * Disallow: /koszyk/ Disallow: /login/

Monitoruj stan indeksowania – korzystaj z narzędzia Google Search Console. Sprawdzaj, które strony są indeksowane, a które pomijane. Reaguj na błędy indeksowania i eliminuj je na bieżąco.

Dlaczego crawl budget jest ważny?

Dobrze zarządzany crawl budget pomaga uniknąć marnowania zasobów na duplikaty treści, błędy 404 i strony o niskiej wartości. Jak skupić uwagę robotów Google na najważniejszych podstronach? Kluczem jest uporządkowana struktura witryny, logiczne linkowanie wewnętrzne i eliminacja problemów technicznych. W ten sposób zwiększasz szanse na wyższe pozycje w wynikach wyszukiwania.

Czy Google Search Console może pomóc? Tak! Regularna analiza danych w Google Search Console pozwala kontrolować, jak roboty przeszukują Twoją stronę. Szybsze ładowanie, dobrze przygotowana mapa witryny i usunięcie barier technicznych sprawiają, że roboty łatwiej docierają do kluczowych treści. To z kolei poprawia widoczność strony w Google i przyciąga więcej odwiedzających.

Narzędzia do monitorowania i optymalizacji

1. Google Search Console

Bezpłatne narzędzie od Google – sprawdza wydajność strony, analizuje ruch organiczny oraz identyfikuje błędy techniczne.

2. Crawlery zewnętrzne

Screaming Frog SEO Spider przeskanuje stronę pod kątem technicznych aspektów SEO. Wykryje niedziałające linki, problemy z metadanymi czy zduplikowaną treść.

3. Analiza logów serwera

Zrozum, jak wyszukiwarki indeksują Twoją stronę dzięki analizatorom logów, takim jak Screaming Frog Logfile Analyzer. Idealne rozwiązanie dla zaawansowanych audytów SEO.

Analiza logów serwera może pomóc w optymalizacji crawl budget witryny poprzez identyfikację problemów z indeksowaniem.

4. Analiza backlinków – mocne linki prowadzące do Twojej strony

Zadbaj o jakość profilu linkowego – wykorzystaj Ahrefs i Majestic. Sprawdz, które linki wspierają Twoje SEO, a które mogą zaszkodzić.

Crawl budget – o czym jeszcze warto pamiętać?

Jeśli prowadzisz sklep online z wieloma kategoriami i produktami, priorytetyzuj:

- Nowości oraz najpopularniejsze produkty.

- Strony z wysokim współczynnikiem konwersji.

- Karty produktów z unikalnymi opisami zamiast stron z niskiej jakości treścią (np. zduplikowane opisy).

Rada eksperta:

Upewnij się, że niepotrzebne strony, jak filtry czy nieużywane parametry URL, są blokowane w pliku robots.txt lub za pomocą tagu noindex. Zaoszczędzisz crawl budget na istotnych zasobach.

Przykład 2: Blog ekspercki z rozbudowaną strukturą treści

W przypadku blogów kluczowe będzie:

- Regularne aktualizowanie starszych, ale wartościowych treści.

- Przekierowanie przestarzałych artykułów do bardziej aktualnych.

- Wewnętrzne linkowanie między popularnymi artykułami a nowymi wpisami, aby zwiększyć ich widoczność.

Rada eksperta:

Wykorzystuj narzędzia takie jak Google Search Console lub Screaming Frog, aby monitorować, które strony są najczęściej indeksowane. Analiza ta pomoże w optymalizacji struktury linków wewnętrznych i eliminacji martwych zasobów.

Utrzymanie strony w doskonałej formie

Twoja strona może działać bez zarzutu i być dobrze widoczna w wynikach wyszukiwania. Jeśli chcesz podnieść jej pozycję w Google skup się na eliminacji błędów technicznych oraz efektywnym zarządzaniu zasobami, by maksymalnie wykorzystać potencjał indeksowania.

Regularne audyty techniczne

Przeprowadzaj cykliczne audyty techniczne, aby identyfikować problemy mogące wpływać na wydajność witryny. Narzędzia takie jak Screaming Frog lub Sitebulb wykrywają zduplikowane treści, błędy 404 oraz inne problemy, które marnują crawl budget.

Optymalizacja crawl budget

Blokuj indeksowanie nieistotnych stron (np. stron wyników wyszukiwania wewnętrznego) w pliku robots.txt. Skup się na priorytetyzacji najważniejszych stron, takich jak produkty czy usługi generujące przychody.

Unikanie stron paginacji w mapie witryny (sitemap) może poprawić efektywność indeksowania, ponieważ niewłaściwe adresy, takie jak te prowadzące do stron paginacji, mogą negatywnie wpływać na crawl budget oraz wydajność skanowania witryny.

Zarządzanie linkowaniem wewnętrznym

Popraw strukturę linków wewnętrznych, aby roboty wyszukiwarek łatwiej docierały do kluczowych sekcji witryny. Unikaj stron osieroconych (bez linków prowadzących do nich) oraz nadmiarowych przekierowań, które spowalniają indeksowanie.

Rozwiązanie problemów technicznych

Upewnij się, że wszystkie linki wewnętrzne prowadzą do stron o statusie 200 OK. Zaktualizuj lub przekieruj strony z błędami 404. Zoptymalizuj czas ładowania strony, ponieważ wolne witryny ograniczają liczbę stron indeksowanych przez roboty.

Wpływ wersji mobilnej strony na crawl budget – czy Googlebot Mobile indeksuje efektywniej?

Od momentu wprowadzenia przez Google indeksowania mobilnego, priorytetem dla robotów wyszukiwarki stały się wersje mobilne stron internetowych. To oznacza, że Googlebot Mobile jako główny robot indeksujący analizuje treści zoptymalizowane pod urządzenia mobilne. Jak wpływa to na crawl budget? Czy wersja mobilna może pomóc w efektywniejszym zarządzaniu zasobami indeksowania?

Googlebot przydziela określony czas na skanowanie danej stronie internetowej, co wpływa na crawl budget. Monitorowanie wydajności serwera oraz komfortu użytkowników jest kluczowe, aby Googlebot mógł efektywnie indeksować strony internetowe.

Mobile-First Indexing to podejście, w którym Google ocenia Twoją stronę głównie na podstawie jej wersji mobilnej, a nie desktopowej. Zostało to wprowadzone, aby dostosować wyszukiwarkę do zmieniających się nawyków użytkowników – obecnie większość ruchu internetowego pochodzi z urządzeń mobilnych.

Od lipca 2019 roku Mobile-First Indexing jest domyślnie stosowane dla wszystkich nowych stron. Starsze witryny zostały stopniowo przenoszone do tego indeksowania.

Jak Mobile-First Indexing wpływa na crawl budget?

Crawl budget odnosi się do liczby stron, które robot Google może przeskanować w określonym czasie. Mobile-First Indexing zmienia sposób, w jaki Google rozdziela swój budżet indeksowania.

Najważniejsze zmiany:

Priorytet dla wersji mobilnych. Googlebot Mobile odwiedza stronę częściej niż Googlebot Desktop, więc zoptymalizowana wersja mobilna ma większe szanse na skuteczne indeksowanie.

Optymalizacja szybkości ładowania. Strony mobilne muszą działać szybciej, co pozytywnie wpływa na efektywność crawlowania – im krótszy czas ładowania, tym więcej stron może zostać przeskanowanych.

Unikanie duplikacji treści. Wersje mobilne i desktopowe muszą być zgodne, by roboty nie marnowały zasobów na analizowanie rozbieżności między nimi.

Zasoby mobilne – obrazy i multimedia. Strony o dużych plikach graficznych lub zasobach wideo szybciej wyczerpują crawl budget, jeśli nie zostaną odpowiednio zoptymalizowane.

Jak zarządzać linkami nofollow w kontekście crawl budget? Czy warto je stosować?

Atrybut nofollow to oznaczenie w kodzie HTML, które informuje roboty wyszukiwarek, aby:

- Nie przekazywały link juice (mocy SEO) z jednej strony na drugą.

- Nie podążały za linkiem w celu indeksowania podlinkowanej strony.

Przykład kodu:

html <a href="https://przyklad.pl" rel="nofollow">Sprawdź ofertę</a>Czy Googlebot podąża za linkami nofollow?

Od marca 2020 roku Google zmieniło podejście do obsługi atrybutu nofollow. Jest on teraz traktowany jako wskazówka (hint), a nie jako bezwzględna reguła. Oznacza to, że:

- Googlebot może, ale nie musi śledzić linki oznaczone jako nofollow.

- Takie linki mogą być zindeksowane, jeżeli Google uzna, że są istotne dla użytkownika.

Jak nofollow wpływa na crawl budget?

- Oszczędzanie crawl budget – mit czy fakt? Dawniej sądzono, że linki nofollow pomagają oszczędzać crawl budget, ponieważ roboty je pomijają. Jednak teraz, gdy traktowane są jako „wskazówka”, roboty mogą je mimo wszystko śledzić, co nie gwarantuje oszczędności zasobów indeksowania.

- Nieefektywne użycie nofollow może marnować crawl budget Jeżeli kluczowe strony zostaną oznaczone jako nofollow, roboty mogą je ignorować lub odwiedzić je później, tracąc zasoby indeksowania na mniej istotne treści.

- Nawigacja i crawl budget. Linki nofollow używane w nawigacji (np. w menu) zaburzają przepływ link juice i powodują, że kluczowe podstrony będą gorzej zindeksowane.

Aktualizacja treści a crawl budget – czy warto odświeżać stare strony?

Aktualizacja istniejących treści to jeden z najskuteczniejszych sposobów na optymalizację crawl budget i poprawę widoczności strony w Google. Roboty wyszukiwarek priorytetowo traktują dynamiczne witryny, które regularnie wprowadzają zmiany. Uznają je za bardziej wartościowe dla użytkowników. W ten sposób odświeżone treści są częściej indeksowane, co zwiększa szanse na wyższe pozycje w wynikach wyszukiwania. Ponadto aktualizacje eliminują błędy, poprawiają strukturę strony i dodają nowe słowa kluczowe, dodatkowo podnosząc jej atrakcyjność w oczach Google.

Skuteczna aktualizacja treści powinna koncentrować się na stronach z potencjałem do osiągnięcia lepszych wyników. Wzbogać treści o nowe informacje, optymalizacja meta tagów i nagłówków oraz usprawnienie linkowania wewnętrznego. Warto również dodać nowe multimedia, takie jak grafiki czy filmy, które zwiększą czas przebywania użytkowników na stronie. Takie działania przyciągną uwagę robotów indeksujących oraz poprawią doświadczenie użytkownika.

Jak efektywnie odświeżać treści?

- Zidentyfikuj strony z malejącym ruchem za pomocą Google Search Console.

- Popraw meta tytuły, opisy i nagłówki, dostosowując je do aktualnych słów kluczowych.

- Dodaj nowe dane, statystyki i odpowiedzi na pytania użytkowników.

- Usprawnij linkowanie wewnętrzne, łącząc aktualizowane treści z innymi stronami.

- Optymalizuj multimedia, kompresując obrazy i dodając filmy lub infografiki.

Optymalizacja crawl budget dla lepszych wyników wyszukiwania

Już wiesz, że crawl budget to jeden z kluczowych elementów strategii SEO, który może znacząco wpłynąć na widoczność Twojej strony. Przygotowaliśmy jeszcze krótkie podsumowanie i kilka wskazówek, jak go efektywnie zarządzać:

- Struktura strony: Utrzymuj płaską hierarchię stron, aby roboty mogły łatwiej indeksować ważne treści. Upewnij się, że najważniejsze strony są dostępne w maksymalnie 3 kliknięciach od strony głównej.

- Jakość treści: Eliminuj duplikaty i twórz unikalne, wartościowe treści. To zwiększy szanse na częstsze indeksowanie przez roboty Google.

- Szybkość ładowania: Optymalizuj kod HTML, CSS i JavaScript, oraz kompresuj obrazy, aby przyspieszyć pobieraniu strony i zwiększyć efektywność indeksowania. Dodatkowo zwróć uwagę na proces pobieraniu strony, który może być spowolniony przez nieoptymalne zasoby.

- Linki wewnętrzne: Dodaj linki prowadzące do kluczowych podstron, aby ułatwić robotom nawigację po Twojej stronie.

- Statusy HTTP: monitoruj statusy HTTP i naprawiaj błędy, takie jak 404, aby uniknąć marnowania crawl budget.

- Plik robots.txt i sitemap: Upewnij się, że plik robots.txt nie blokuje ważnych stron, a mapa strony zawiera tylko aktualne adresy URL.

Dzięki tym wskazówkom możesz poprawić efektywność indeksowania i zwiększyć widoczność Twojej strony w wynikach wyszukiwania.

Potrzebujesz pomocy w SEO swojej firmy?

W Rodin zajmiemy się pozycjonowaniem Twojej strony w Google!

Więcej klientów, większe zyski. Pozycjonujemy strony, które trafiają na szczyt wyników Google. Tworzymy kampanie reklamowe, które docierają do osób gotowych na zakup. Projektujemy nowoczesne strony WWW, które przyciągają uwagę i sprzedają.

Skuteczny marketing, który działa. Budujemy rozpoznawalność marki w social mediach. Tworzymy kampanie e-mailowe, które angażują i sprzedają. Szkolimy z SEO, reklam i copywritingu, by Twój biznes rósł jeszcze szybciej.

Skontaktuj się z nami! Nasz zespół ekspertów opracuje dla Ciebie skuteczną strategię marketingową, dostosowaną do Twoich celów biznesowych.